La escasez de chips de IA continúa, pero puede haber un final a la vista

Aunque las GPU tienen una gran demanda, todavía necesitan chips de memoria de alto rendimiento para las aplicaciones de IA

La adopción de la inteligencia artificial (IA) generativa continúa en aumento y la infraestructura para respaldar ese crecimiento se encuentra actualmente con una fuerte brecha entre la oferta y la demanda. Según un análisis de IDC, el 66% de las empresas de todo el mundo invertirán en esta tecnología durante los próximos 18 meses. En 2024, la infraestructura representará el 46% del gasto total. El problema es que una pieza clave de hardware necesaria para su construcción escasea.

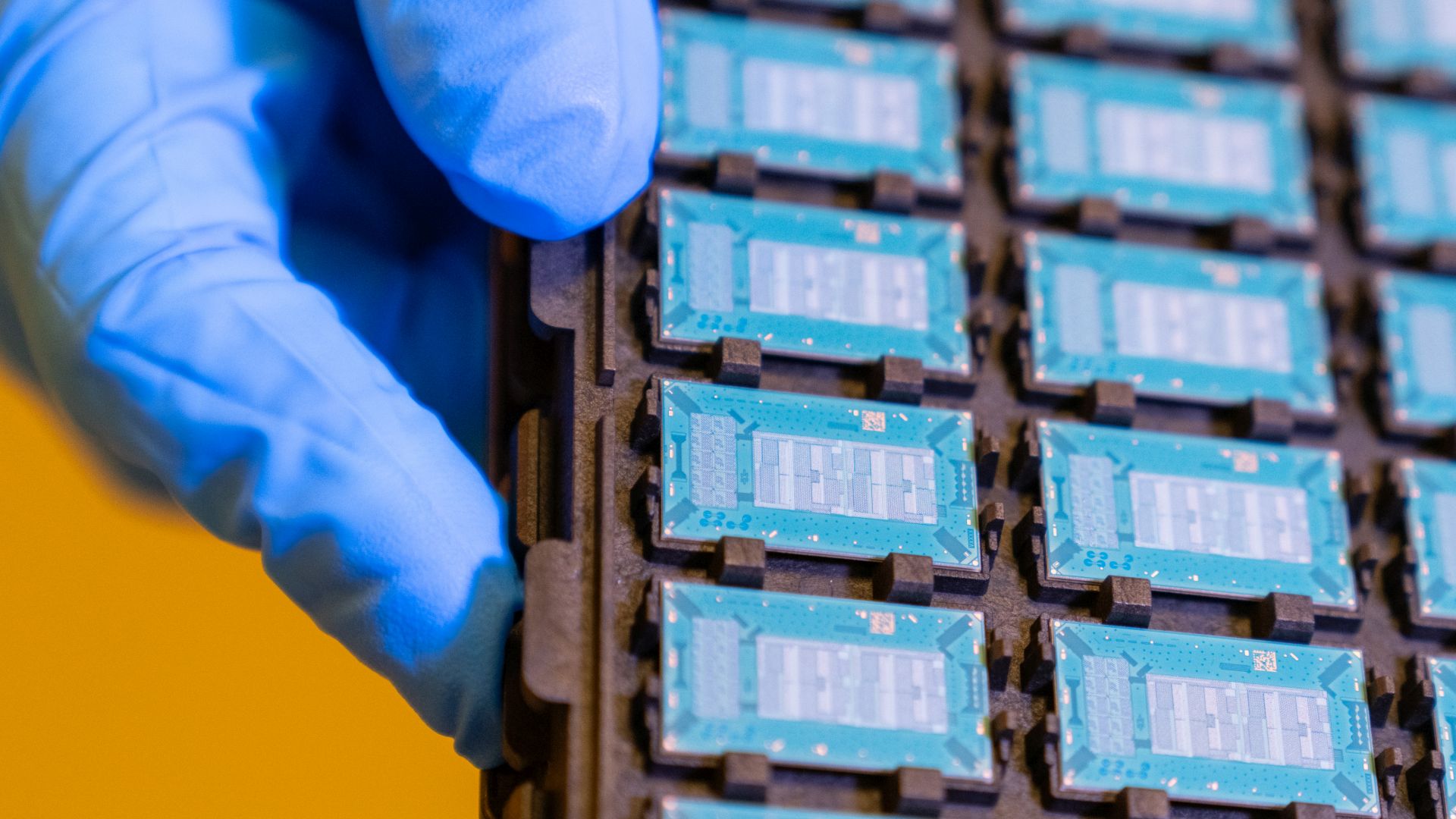

El ritmo vertiginoso de la adopción de la IA en los últimos dos años ha puesto a prueba la capacidad de la industria para suministrar los chips especiales de alto rendimiento necesarios para ejecutar las operaciones intensivas de procesos. La mayor parte de la atención sobre la escasez de procesadores se ha centrado en la creciente demanda de GPU Nvidia y alternativas de varios diseñadores de chips como AMD, Intel y los operadores de centros de datos a hiperescala, según Benjamin Lee, profesor del Departamento de Informática y Ciencias de la Información de la Universidad de Pensilvania. "Se ha prestado mucha menos atención a la explosión de la demanda de chips de memoria de gran ancho de banda, que se fabrican en fundiciones con sede en Corea dirigidas por SK Hynix".

La semana pasada, SK Hynix dijo que sus productos de memoria de alto ancho de banda (HBM), que se necesitan en combinación con GPU de alto rendimiento para manejar los requisitos de procesamiento de IA, están casi completos hasta 2025 debido a la alta demanda. El precio de los HBM también ha aumentado recientemente entre un 5% y un 10%, impulsado por importantes primas y mayores necesidades de capacidad para los chips de IA, según la firma de investigación de mercado TrendForce.

Se espera que los chips HBM representen más del 20% del valor total del mercado de DRAM a partir de 2024, y potencialmente superen el 30% para 2025, según la vicepresidenta senior de investigación de TrendForce, Avril Wu. "No todos los proveedores importantes han superado las calificaciones de los clientes para [HBM de alto rendimiento], lo que lleva a los compradores a aceptar precios más altos para asegurar suministros estables y de calidad".

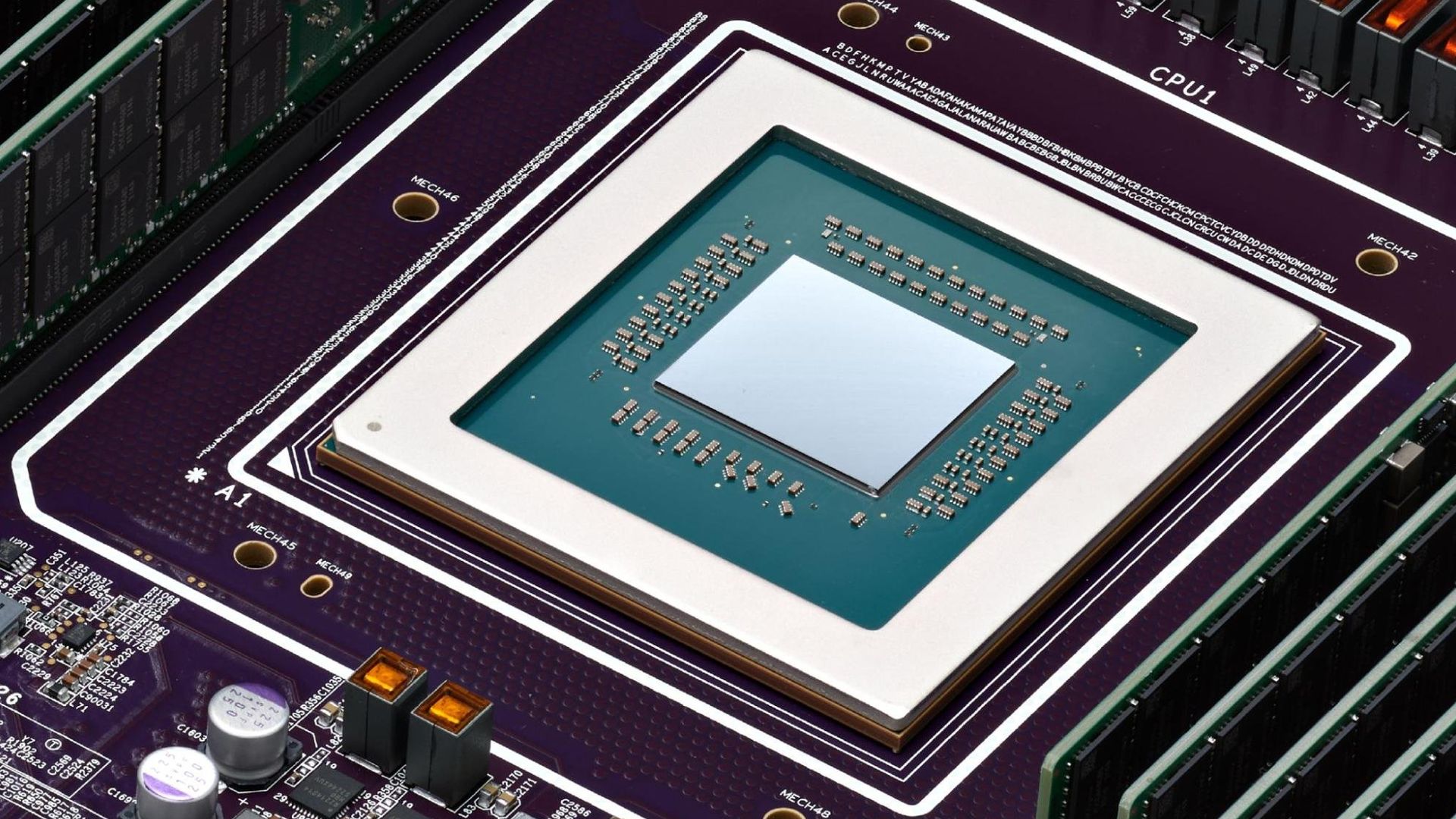

Por qué las GPU necesitan memoria de gran ancho de banda

Según Lee, sin los chips HBM, el sistema de memoria del servidor de un centro de datos no podría seguir el ritmo de un procesador de alto rendimiento, como una GPU. Los HBM son los que suministran a las GPU los datos que procesan. "Cualquiera que compre una GPU para computación de IA también necesitará una memoria de gran ancho de banda".

“En otras palabras, las GPU de alto rendimiento se utilizarían mal y, a menudo, permanecerían inactivas esperando transferencias de datos. En resumen, la alta demanda de chips de memoria SK Hynix se debe a la alta demanda de chips GPU de Nvidia y, en menor medida, a la demanda de chips de IA alternativos, como los de AMD, Intel y otros”, expresa.

"HBM es relativamente nuevo y está ganando un fuerte impulso debido a lo que ofrece HBM: más ancho de banda y capacidad", dice Gaurav Gupta, analista de Gartner. “Es diferente a lo que venden Nvidia e Intel. Con excepción de SK Hynix, la situación para HBM es similar para otros reproductores de memoria. Para Nvidia, creo que existen limitaciones, pero más asociadas con la capacidad de empaquetar sus chips con las fundiciones”.

Mientras SK Hynix está alcanzando sus límites de suministro, Samsung y Micron están aumentando la producción de HBM y deberían poder satisfacer la demanda a medida que el mercado se vuelve más distribuido, según Lee. La escasez actual de HBM se produce principalmente en los envases de TSMC (es decir, chip-on-wafer-on-substrate o CoWoS), que es el proveedor exclusivo de la tecnología. Según Lee, TSMC está duplicando con creces su capacidad SOIC y aumentando la capacidad para CoWoS en más del 60%. "Espero que la escasez disminuya a finales de este año".

Al mismo tiempo, más proveedores de embalaje y fundición se están conectando y calificando su tecnología para admitir NVIDIA, AMD, Broadcom, Amazon y otros que utilizan la tecnología de embalaje de chips de TSMC, según Lee.

Se espera que Nvidia, cuya producción representa alrededor del 70% del suministro global de chips para servidores de IA , genere 40.000 millones de dólares en ingresos por las ventas de GPU este año, según analistas de Bloomberg. En comparación, se espera que los competidores Intel y AMD generen 500 millones de dólares y 3.500 millones de dólares, respectivamente. Pero los tres están aumentando la producción lo más rápido posible.

Según TrendForce, Nvidia está abordando la escasez de suministro de GPU aumentando sus capacidades de producción de CoWoS y HBM. “Se espera que este enfoque proactivo reduzca a la mitad el tiempo de entrega promedio actual de 40 semanas para el segundo trimestre [de 2024], a medida que nuevas capacidades comiencen a estar en línea”, dice el informe TrendForce en su informe. "Esta expansión tiene como objetivo aliviar los cuellos de botella de la cadena de suministro que han obstaculizado la disponibilidad de los servidores de IA debido a la escasez de GPU".

Shane Rau, vicepresidente de investigación de semiconductores informáticos de IDC, dijo que si bien la demanda de capacidad de chips de IA es muy alta, los mercados se están adaptando. “En el caso de las GPU de tipo servidor, están aumentando la oferta de obleas, embalajes y memorias. El aumento de la oferta es clave porque, debido a su rendimiento y programabilidad, las GPU de clase servidor seguirán siendo la plataforma elegida para entrenar y ejecutar grandes modelos de IA”.

Los fabricantes de chips luchan por satisfacer la demanda de IA

Se espera que el gasto mundial en chips centrados en IA alcance los 53.000 millones de dólares este año y que se duplique con creces en los próximos cuatro años, según Gartner. Por eso no sorprende que los fabricantes de chips estén lanzando nuevos procesadores tan rápido como pueden.

Intel ha anunciado sus planes para chips destinados a potenciar funciones de IA con sus procesadores Gaudi 3, y ha dicho que sus procesadores Xeon 6, que pueden ejecutar procesos de generación aumentada de recuperación (RAG), también serán clave. La GPU Gaudi 3 fue diseñada específicamente para entrenar y ejecutar modelos de lenguaje grandes (LLM) masivos que sustentan genAI en centros de datos.

Mientras tanto, AMD en su llamada de resultados más reciente promocionó su GPU MI300 para cargas de trabajo de centros de datos de IA, que también tiene una buena tracción en el mercado, según el vicepresidente del grupo IDC, Mario Morales, y añade que la firma de investigación está rastreando a más de 80 proveedores de semiconductores que desarrollan chips especializados. para IA.

En el lado del software de la ecuación, los creadores de LLM también están desarrollando modelos más pequeños diseñados para tareas específicas; requieren menos recursos de procesamiento y dependen de datos propietarios locales, a diferencia de los algoritmos masivos y amorfos que cuentan con cientos de miles de millones o incluso más de un billón de parámetros.

La estrategia de Intel en el futuro es similar: quiere habilitar la IA generativa en todo tipo de dispositivo informático, desde computadoras portátiles hasta teléfonos inteligentes. Los procesadores Intel Xeon 6 incluirán algunas versiones con unidades de procesamiento neuronal integradas (NPU o “aceleradores de IA”) para su uso en estaciones de trabajo, PC y dispositivos periféricos. Intel también afirma que sus procesadores Xeon 6 serán lo suficientemente buenos para ejecutar LLM más pequeños y personalizados.

Aun así, sin los HBM, esos procesadores probablemente tendrían dificultades para mantenerse al día con las demandas de alto rendimiento de IA generativa.